大数据开发操作文档 文档发布于:2020-12-28

登录开发平台

在浏览器输入网址:https://dev.flydiysz.cn:8887/default-front-datafactory/main/pagedirectory_developer/developer-list 然后输入用户名、密码登录即可

进入开发者中心,点击新建任务

输入任务名称、创建人、备注并确认保存

选择新建任务的任务,点击编辑进入页面

任务首页

根据任务名称新建流程:

1)、选择数据源

点击数据源面板,选择一个组件,拖拽至流程面板,右键编辑(或组件面板的参数管理),进入组件参数管理,输入数据库连接信息,选择需要操作的库表并保存

组件参数管理

2)、选择采集组件

点击采集面板,选择一个组件,拖拽至流程面板,右键编辑(或组件面板的参数管理),进入组件参数管理,输入数据库连接信息,选择需要操作的库表并保存

配置:canal

选择主题、消费组

3)、选择计算面板

点击计算面板,选择一个组件,拖拽至流程面板,输入sql语句,选择集群配置并保存

流程面板

部署完成,点击工具栏启动,开始执行

一、组件使用

1.Mysql组件

1.1 Mysql的链接

在MySQL的编辑界面,输入MySQL的host,port,用户名和密码,点击链接按钮,就可以看到所有的数据库和表以及字段信息。

1.2 Mysql自定义字段

可以选择多个字段和表,也可以新增一个字段,后续可以自动生成对应的Java实体类。

2.Excel组件

支持上传一个Excel文件,并解析Excel文件,保存到数据库和hive中。

3.Flume组件

在Flume组件中配置好脚本文件,可以在服务器上自动生成一个脚本。

4.Kafka组件

在Kafka组件中输入连接的host和port,可以查询出对应的topic。也可以新建一个topic。

5.Datax组件

在Datax组件中可以选择上游和下游数据源,并在对应的数据源中输入参数,就可以生成对应的datax脚本。

6.Sqoop组件

在Sqoop组件中配置好脚本文件,可以在服务器上自动生成一个脚本。

7.ES组件

支持在ES组件中输入host和port,就可以查询出对应的index。也可以自己新建一个index。

8.LogServer组件

LogServer组件可以查看远程服务器的目录。

9.Flink组件

可以在flink组件中查看Mysql选择的库表字段信息,方便对照输入flinksql语句。

二、已实现的场景

1.实时场景

Flink实时消费Kafka中的数据并写入到ES

1.2 各个组件参数配置

Mysql的参数配置:选择源数据的表和字段

Kafka的参数配置:选择要消费的主题

Flink的参数配置:输入对应的flinksql语句

ES的参数配置:选择要sink的index

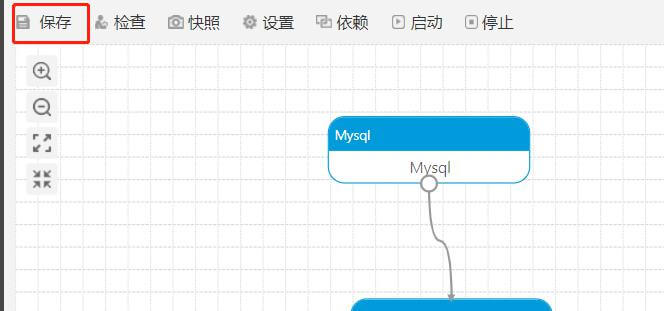

点击主页的保存按钮,可以自动生成代码,并上传到git上

点击启动按钮,就可以运行flink的job

2.离线场景一

使用Datax同步Mysql数据到Hive中

2.1各个组件的参数配置

Mysql的参数配置:选择要同步的数据源

Datax的参数配置:输入sink到hdfs的url、路径等信息

点击主页的保存按钮,就可以自动生成datax的脚本文件

点击启动按钮,就可以执行datax

3.离线场景二

使用Flume采集日志文件,输入到Hdfs和Hive中

3.1各个组件的参数配置

Text组件的参数配置

Hdfs组件参数

点击主页的保存按钮,即可生成flume的配置文件

配置文件效果如下:

点击启动,就可以实现flume采集日志到hdfs和hive中

4.离线场景三

使用sqoop工具,将mysql中的数据导入到hive中

4.1各个组件的参数配置

Mysql组件的参数,选择源数据

Sqoop组件的参数配置,输入执行脚本,会自动生成脚本文件

注意:该功能后续会做优化,简化录入脚本的步骤

点击启动按钮,就可以实现sqoop将mysql数据导入到hive中

在hive中查询数据,效果如下